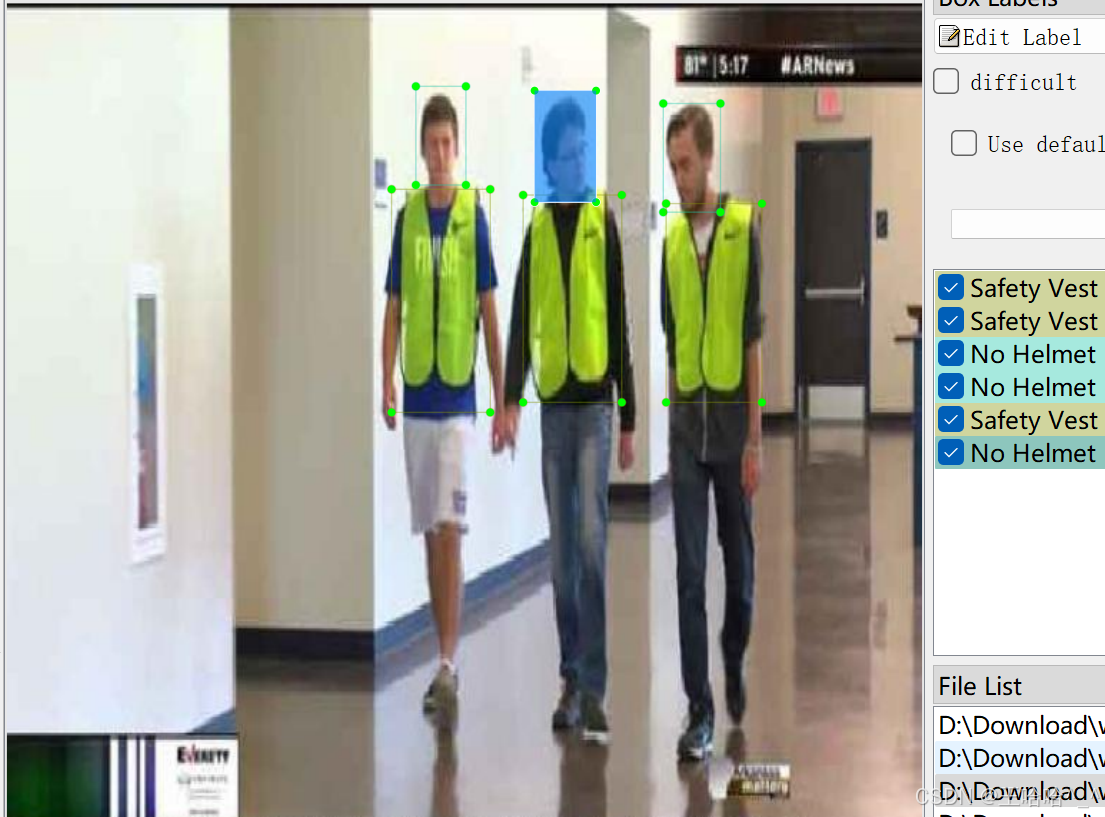

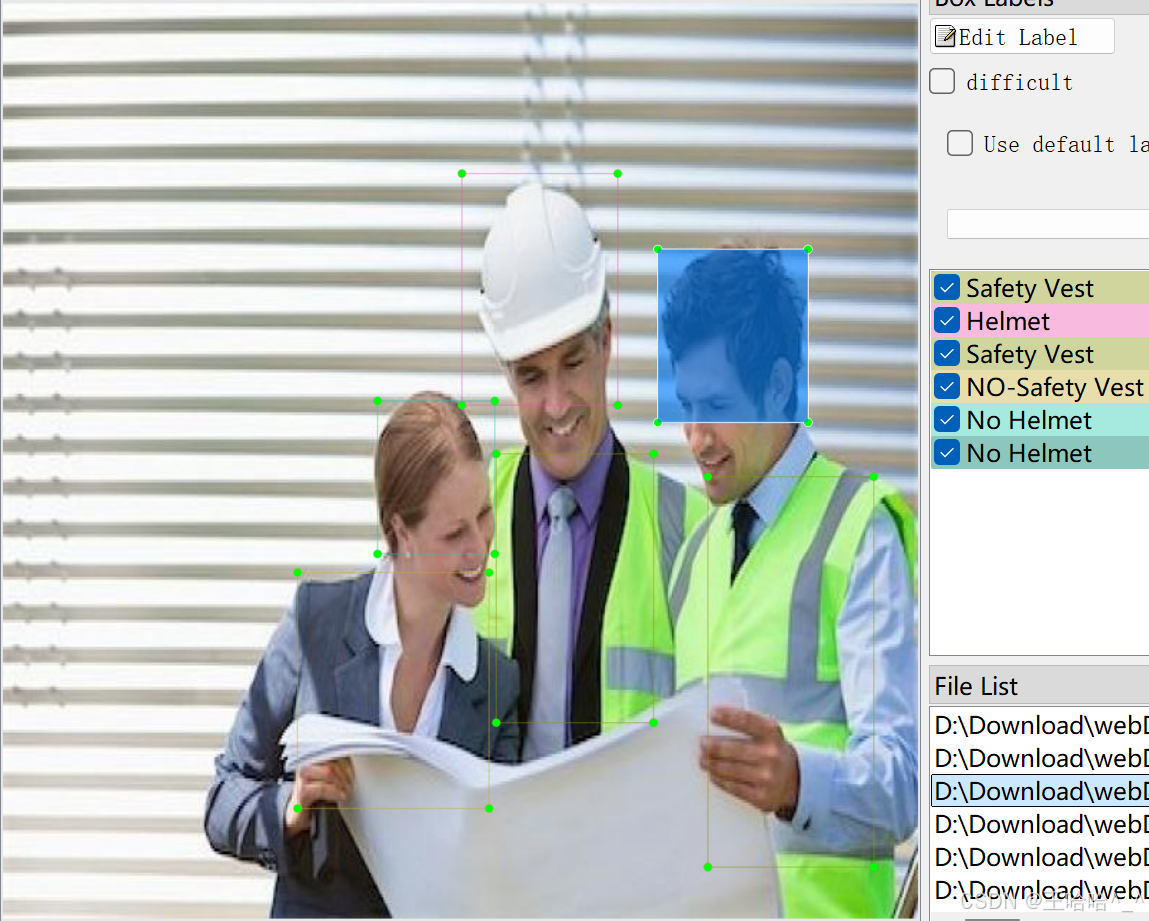

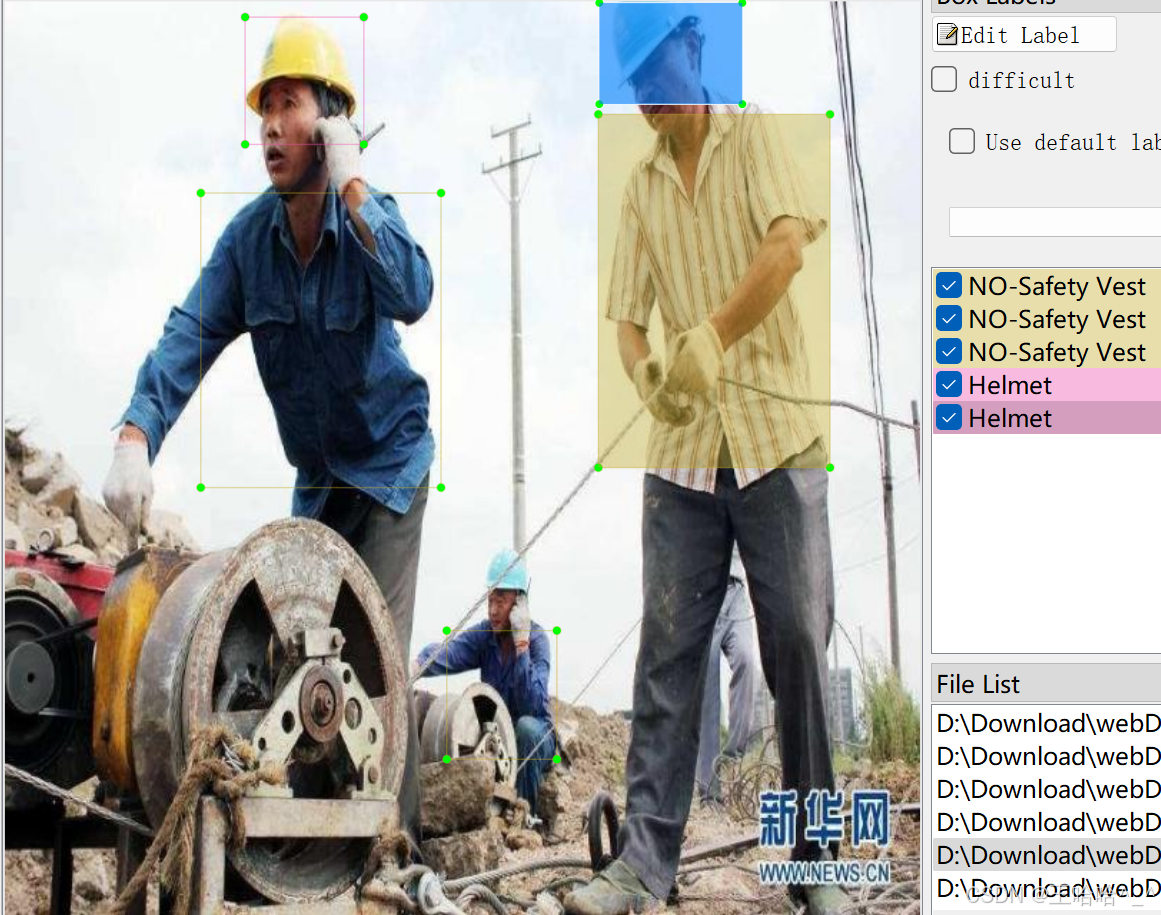

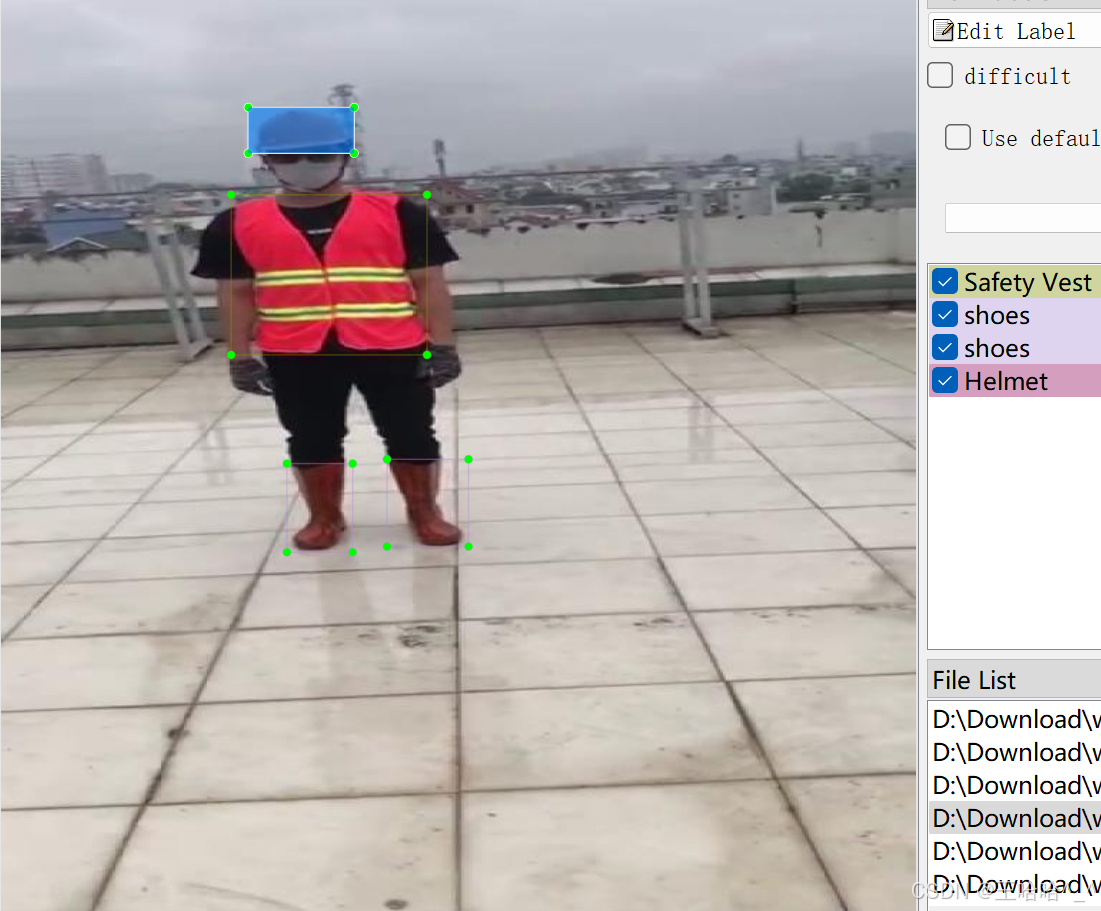

一、数据集介绍【数据集】安全帽、反光衣识别数据集 9911 张,目标检测,包含YOLO/VOC格式标注。 数据集中包含5种分类:names:['Helmet', 'NO-Safety Vest', 'No Helmet', 'Safety Vest', 'shoes'],表示"安全帽、未穿戴反光衣、未穿戴安全帽、反光衣、安全鞋"。 数据集图片来自国内外网站、网络爬虫等; 可用于施工区域人身安全设备识别。 检测场景为建筑工地、道路施工等高风险作业环境中,可以应用于提高工地安全管理效率、降低安全事故风险等。 更多数据集请查看置顶博文!    1、数据概述施工地工人安全识别的重要性 在建筑工地、道路施工等高风险作业环境中,工人的安全是至关重要的。为了确保工人的安全,工地通常会要求工人佩戴安全帽和反光衣等个人防护装备。然而,由于工地环境复杂,人员流动大,传统的人工监督方式难以做到全面覆盖和实时监控。因此,开发一种能够自动识别工人是否佩戴安全帽和反光衣的目标检测算法,对于提高工地安全管理效率、降低安全事故风险具有重要意义。 基于YOLO的安全帽反光衣识别算法

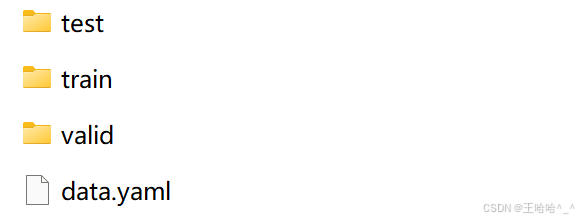

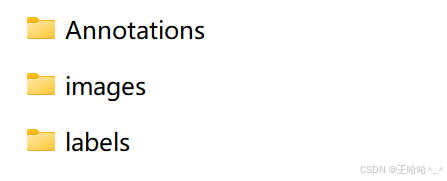

该数据集含有 9911 张图片,包含Pascal VOC XML格式和YOLO TXT格式,用于训练和测试建筑工地、道路施工等高风险作业环境中进行安全帽反光衣等穿戴识别。 图片格式为jpg格式,标注格式分别为: YOLO:txt VOC:xml 数据集均为手工标注,保证标注精确度。 2、数据集文件结构person_safety/ ——test/ ————Annotations/ ————images/ ————labels/ ——train/ ————Annotations/ ————images/ ————labels/ ——valid/ ————Annotations/ ————images/ ————labels/ ——data.yaml

3、数据集适用范围

4、数据集标注结果

4.1、数据集内容

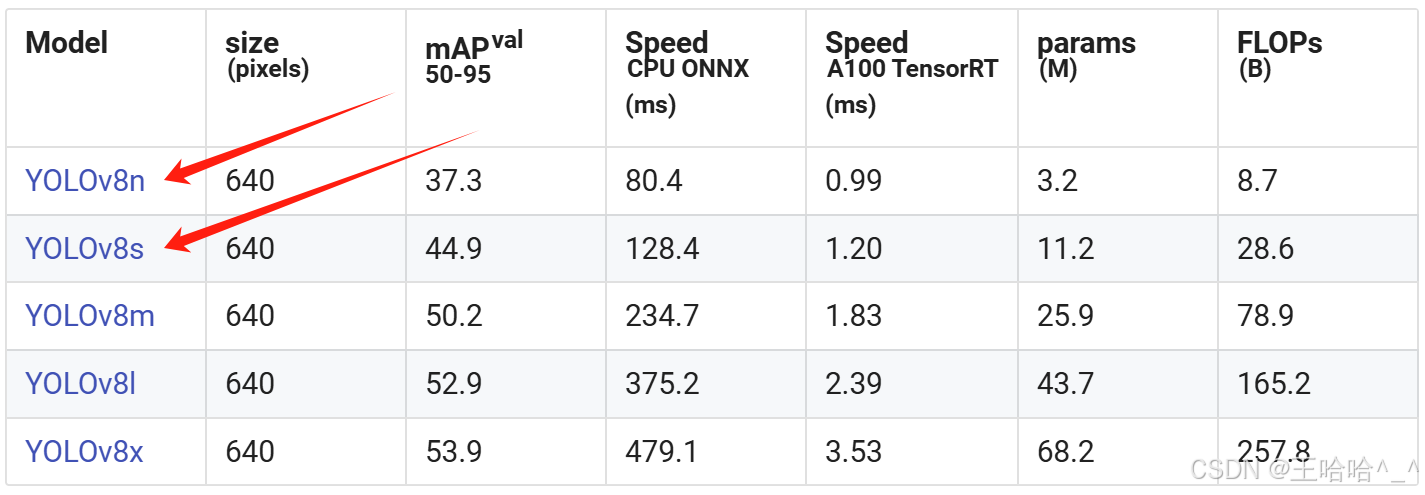

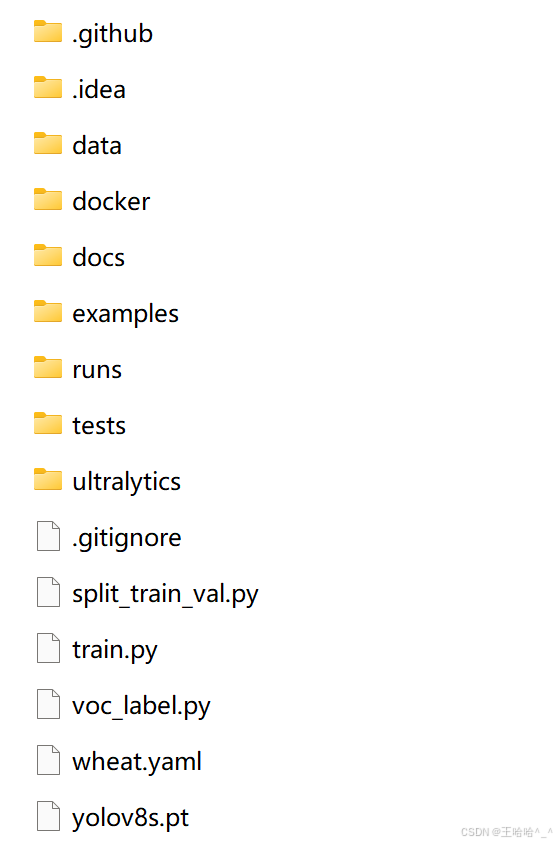

5、训练过程5.1、导入训练数据下载YOLOv8项目压缩包,解压在任意本地workspace文件夹中。 下载YOLOv8预训练模型,导入到ultralytics-main项目根目录下。  在ultralytics-main项目根目录下,创建data文件夹,并在data文件夹下创建子文件夹:Annotations、images、imageSets、labels,其中,将pascal VOC格式的XML文件手动导入到Annotations文件夹中,将JPG格式的图像数据导入到images文件夹中,imageSets和labels两个文件夹不导入数据。 data目录结构如下: data/ ——Annotations/ //存放xml文件 ——images/ //存放jpg图像 ——imageSets/ ——labels/ 整体项目结构如下所示:  5.2、数据分割首先在ultralytics-main目录下创建一个split_train_val.py文件,运行文件之后会在imageSets文件夹下将数据集划分为训练集train.txt、验证集val.txt、测试集test.txt,里面存放的就是用于训练、验证、测试的图片名称。 [code]import os import random trainval_percent = 0.9 train_percent = 0.9 xmlfilepath = 'data/Annotations' txtsavepath = 'data/ImageSets' total_xml = os.listdir(xmlfilepath) num = len(total_xml) list = range(num) tv = int(num * trainval_percent) tr = int(tv * train_percent) trainval = random.sample(list, tv) train = random.sample(trainval, tr) ftrainval = open('data/ImageSets/trainval.txt', 'w') ftest = open('data/ImageSets/test.txt', 'w') ftrain = open('data/ImageSets/train.txt', 'w') fval = open('data/ImageSets/val.txt', 'w') for i in list: name = total_xml[i][:-4] + '\n' if i in trainval: ftrainval.write(name) if i in train: ftrain.write(name) else: fval.write(name) else: ftest.write(name) ftrainval.close() ftrain.close() fval.close() ftest.close()[/code]5.3、数据集格式化处理在ultralytics-main目录下创建一个voc_label.py文件,用于处理图像标注数据,将其从XML格式(通常用于Pascal VOC数据集)转换为YOLO格式。 convert_annotation函数

5.4、修改数据集配置文件在ultralytics-main目录下创建一个wheat.yaml文件 [code]train: data/train.txt val: data/val.txt test: data/test.txt nc: 5 names: ['Helmet', 'NO-Safety Vest', 'No Helmet', 'Safety Vest', 'shoes'][/code]5.5、执行命令执行train.py [code]model = YOLO('yolov8s.pt') results = model.train(data='wheat.yaml', epochs=200, imgsz=640, batch=16, workers=0)[/code]也可以在终端执行下述命令: [code]yolo train data=wheat.yaml model=yolov8s.pt epochs=200 imgsz=640 batch=16 workers=0 device=0[/code]5.6、模型预测你可以选择新建predict.py预测脚本文件,输入视频流或者图像进行预测。 代码如下: [code]import cv2 from ultralytics import YOLO # Load the YOLOv8 model model = YOLO("./best.pt") # 自定义预测模型加载路径 # Open the video file video_path = "./demo.mp4" # 自定义预测视频路径 cap = cv2.VideoCapture(video_path) # Get the video properties frame_width = int(cap.get(cv2.CAP_PROP_FRAME_WIDTH)) frame_height = int(cap.get(cv2.CAP_PROP_FRAME_HEIGHT)) fps = cap.get(cv2.CAP_PROP_FPS) # Define the codec and create VideoWriter object fourcc = cv2.VideoWriter_fourcc(*'mp4v') # Be sure to use lower case out = cv2.VideoWriter('./outputs.mp4', fourcc, fps, (frame_width, frame_height)) # 自定义输出视频路径 # Loop through the video frames while cap.isOpened(): # Read a frame from the video success, frame = cap.read() if success: # Run YOLOv8 inference on the frame # results = model(frame) results = model.predict(source=frame, save=True, imgsz=640, conf=0.5) results[0].names[0] = "道路积水" # Visualize the results on the frame annotated_frame = results[0].plot() # Write the annotated frame to the output file out.write(annotated_frame) # Display the annotated frame (optional) cv2.imshow("YOLOv8 Inference", annotated_frame) # Break the loop if 'q' is pressed if cv2.waitKey(1) & 0xFF == ord("q"): break else: # Break the loop if the end of the video is reached break # Release the video capture and writer objects cap.release() out.release() cv2.destroyAllWindows()[/code]也可以直接在命令行窗口或者Annoconda终端输入以下命令进行模型预测: [code]yolo predict model="best.pt" source='demo.jpg'[/code]6、获取数据集看头像或主页私聊博主哈~ 二、基于QT的目标检测可视化界面1、环境配置[code]# 安装torch环境 pip install torch -i https://pypi.tuna.tsinghua.edu.cn/simple # 安装PySide6依赖项 pip install PySide6 -i https://pypi.tuna.tsinghua.edu.cn/simple # 安装opencv-python依赖项 pip install opencv-python -i https://pypi.tuna.tsinghua.edu.cn/simple[/code]2、使用说明 界面功能介绍:

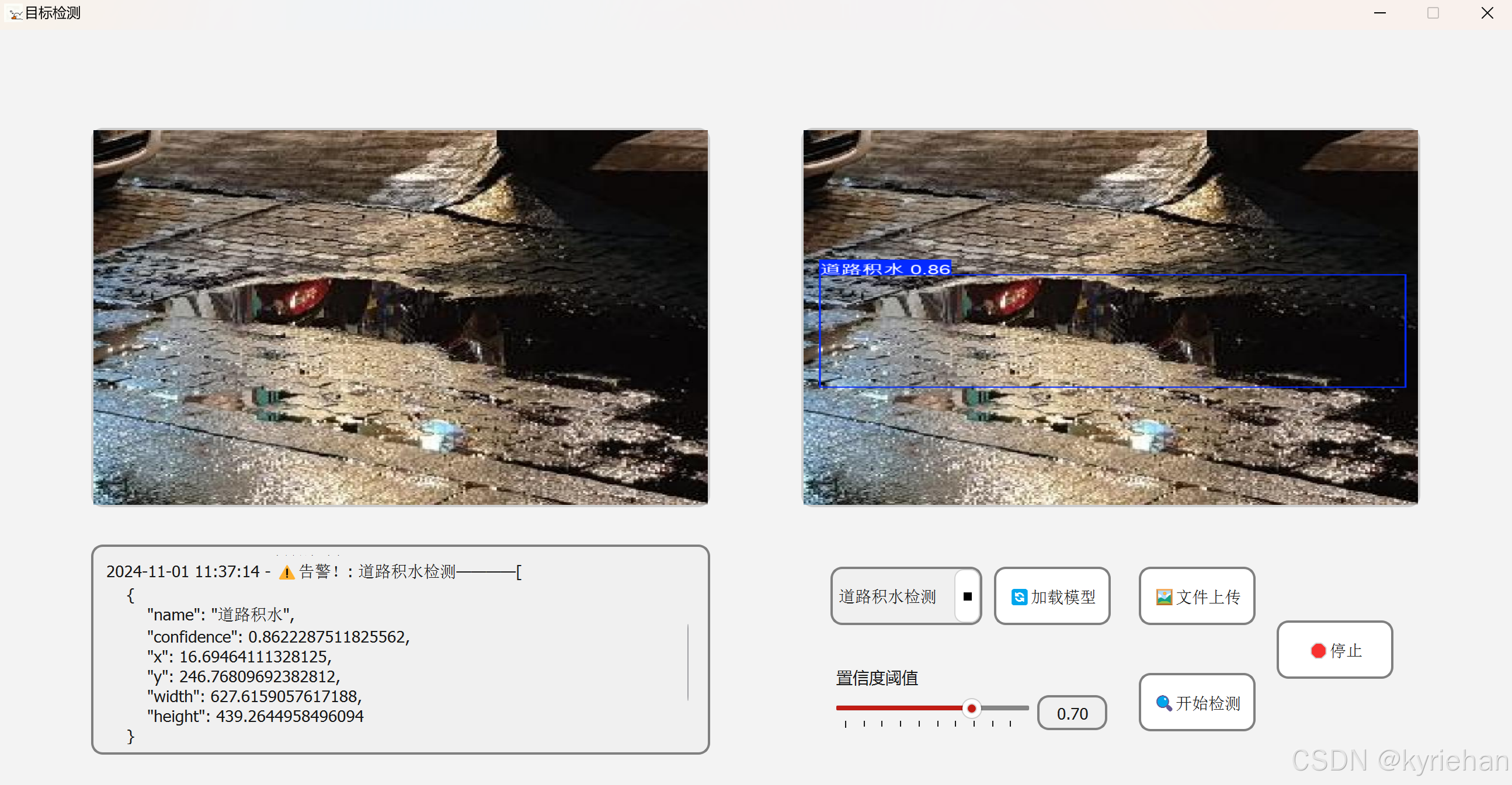

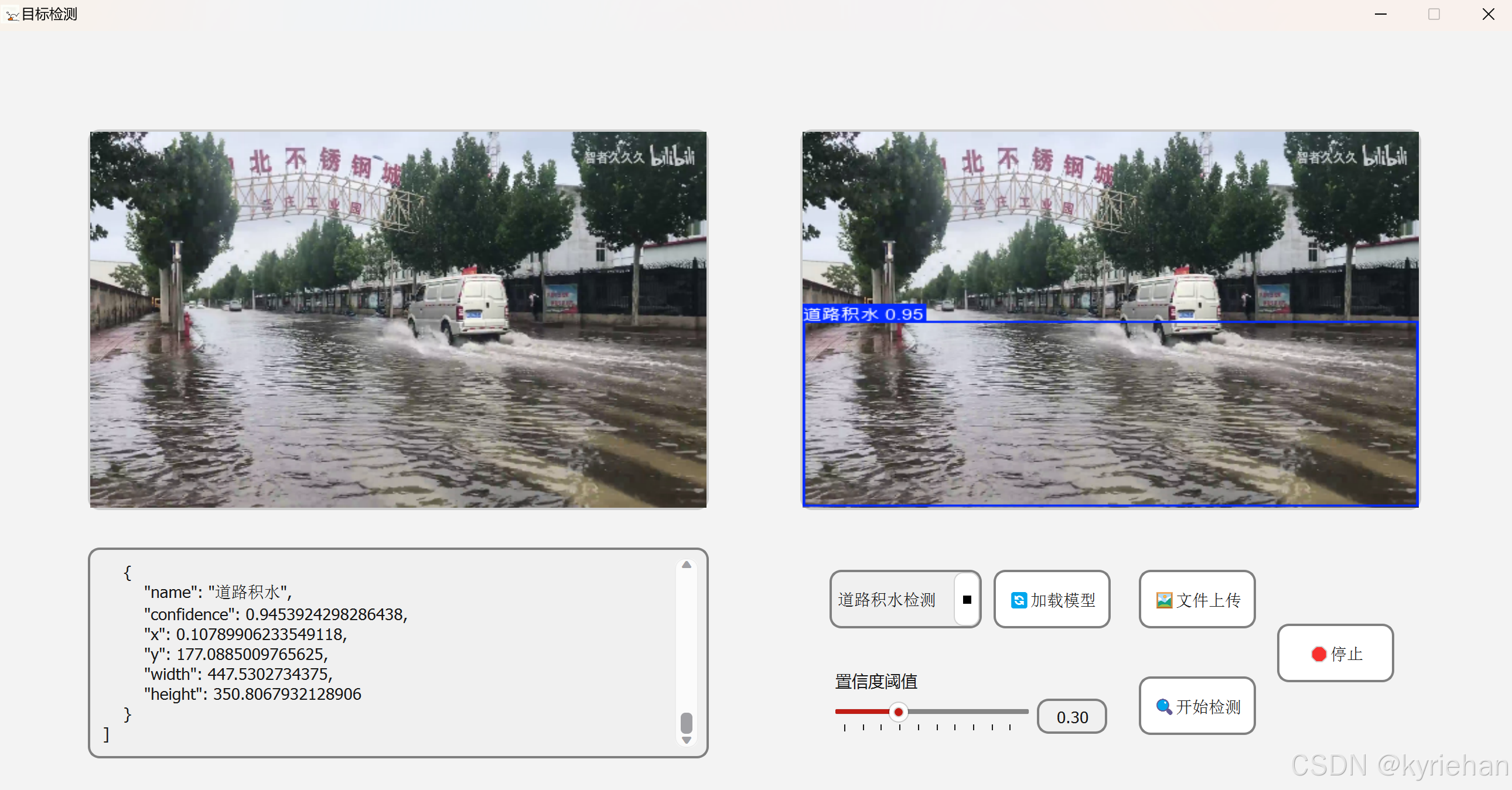

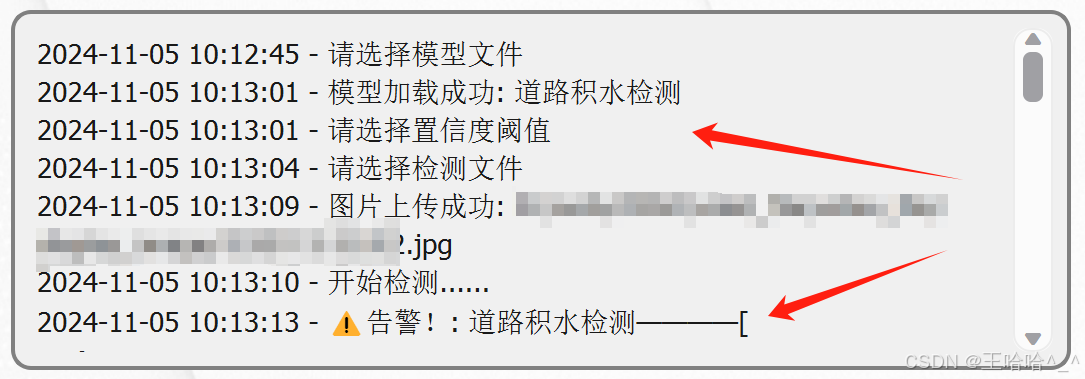

3、预测效果展示3.1、图片检测 切换置信度再次执行:  上图左下区域可以看到json格式的告警信息,用于反馈实际作业中的管理系统,为管理员提供道路养护决策 。 3.2、视频检测 3.3、日志文本框 4、前端代码[code]class MyWindow(QtWidgets.QMainWindow): def __init__(self): super().__init__() self.init_gui() self.model = None self.timer = QtCore.QTimer() self.timer1 = QtCore.QTimer() self.cap = None self.video = None self.file_path = None self.base_name = None self.timer1.timeout.connect(self.video_show) def init_gui(self): self.folder_path = "model_file" # 自定义修改:设置文件夹路径 self.setFixedSize(1300, 650) self.setWindowTitle('目标检测') # 自定义修改:设置窗口名称 self.setWindowIcon(QIcon("111.jpg")) # 自定义修改:设置窗口图标 central_widget = QtWidgets.QWidget(self) self.setCentralWidget(central_widget) main_layout = QtWidgets.QVBoxLayout(central_widget) # 界面上半部分: 视频框 topLayout = QtWidgets.QHBoxLayout() self.oriVideoLabel = QtWidgets.QLabel(self) # 界面下半部分: 输出框 和 按钮 groupBox = QtWidgets.QGroupBox(self) groupBox.setStyleSheet('QGroupBox {border: 0px solid #D7E2F9;}') bottomLayout = QtWidgets.QHBoxLayout(groupBox) main_layout.addWidget(groupBox) btnLayout = QtWidgets.QHBoxLayout() btn1Layout = QtWidgets.QVBoxLayout() btn2Layout = QtWidgets.QVBoxLayout() btn3Layout = QtWidgets.QVBoxLayout() # 创建日志打印文本框 self.outputField = QtWidgets.QTextBrowser() self.outputField.setFixedSize(530, 180) self.outputField.setStyleSheet('font-size: 13px; font-family: "Microsoft YaHei"; background-color: #f0f0f0; border: 2px solid #ccc; border-radius: 10px;') self.detectlabel = QtWidgets.QLabel(self) self.oriVideoLabel.setFixedSize(530, 400) self.detectlabel.setFixedSize(530, 400) self.oriVideoLabel.setStyleSheet('border: 2px solid #ccc; border-radius: 10px; margin-top:75px;') self.detectlabel.setStyleSheet('border: 2px solid #ccc; border-radius: 10px; margin-top: 75px;') topLayout.addWidget(self.oriVideoLabel) topLayout.addWidget(self.detectlabel) main_layout.addLayout(topLayout)[/code]5、代码获取YOLO可视化界面 看头像或主页私聊博主哈~ 更多数据集请查看 以上内容均为原创。 免责声明:本内容来源于网络,如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |