前言

在当今人工智能的蓬勃发展中,大型语言模型(LLMs)以其卓越的能力和广泛的应用,已经在商业和日常生活中扮演了不可或缺的角色。它们在自然语言处理、内容创作、智能助手等多个领域展现出巨大的潜力和价值。然而,这些模型的传统应用往往依赖于云端服务,这不仅带来了数据隐私泄露的风险,还受限于网络连接的稳定性和速度,影响了用户体验。

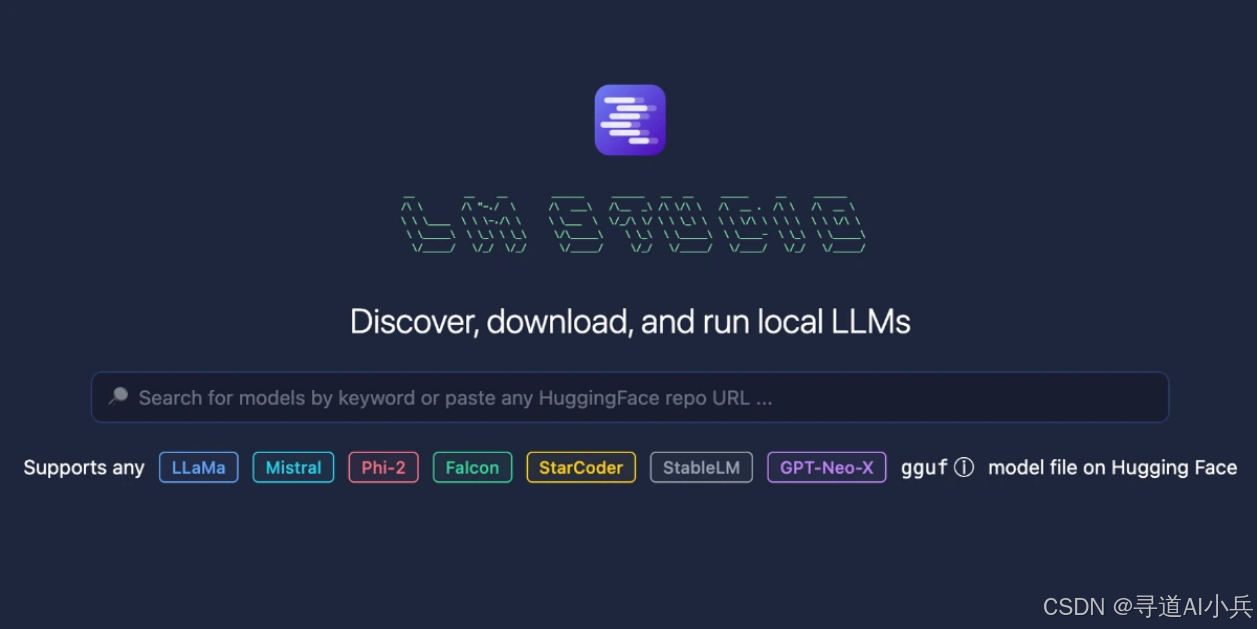

正是在这样的背景下,LM Studio应运而生,它为在本地设备上运行大型语言模型提供了一个创新且高效的解决方案。LM Studio通过优化模型架构和计算资源管理,使得大型语言模型能够在用户的个人设备上运行,无需依赖远程服务器。这样不仅大大减少了对网络的依赖,提高了响应速度,还有效保护了用户数据的隐私安全。

一、LM Studio简介

LM Studio作为一款桌面应用程序,有着鲜明特性。与惯常借助云端服务调用语言模型不同,它聚焦本地设备运用,不管是常见的笔记本电脑,还是台式机,只要硬件配置达标,就能顺利运行各类大型语言模型,变身私人专属的智能处理“终端”。这有效摆脱了网络限制,即便处于无网络环境,或者出于对数据隐私严格保护考量、不愿数据“外流”至云端,用户依旧可凭借它充分挖掘语言模型价值。

二、核心技术剖析

- 广泛的模型兼容性:LM Studio具备出色的模型适配能力,能兼容源自Hugging Face等资源库的大量模型,涵盖热门的Llama

2、实用的MPT以及编程辅助见长的StarCoder等,还有诸多衍生变体。就像为用户打造了一座品类齐全的“模型仓库”,使用者能依据具体工作任务,像文学创作、代码编写、学术研讨等不同需求,精准筛选契合的模型,开启高效智能交互。 - 硬件协同优化策略:依托llama.cpp底层架构支撑,LM Studio深谙硬件协同运作之道。针对NVIDIA系列GPU,运用GPU卸载技术,把模型拆解为精细“子图”,依据硬件算力状况,合理分配运算任务,让GPU和CPU各司其职、协同发力,突破显存局限,显著提升运算速度;在内存管理维度,借助模型量化手段,在保障模型输出质量稳定前提下,降低内存占用量,确保即便设备内存有限,也能平稳加载运行大型模型。

- 便捷交互设计理念:其图形化操作界面秉持简洁易用原则。新手无需应对复杂命令行操作,通过鼠标点击等常规交互,就能在界面流畅完成模型下载、参数精细调整、运行状态监控等系列流程。尤为亮眼的是,内置兼容OpenAI的本地服务器功能,恰似一座“桥梁”,无缝衔接既有基于OpenAI API搭建的应用与本地模型,极大缩短开发适配周期,助力创新应用高效落地。

三、功能亮点聚焦

- 离线运行保障隐私:当下数据安全至关重要,LM Studio的离线运行机制恰似“安全堡垒”。整个数据处理流程均在本地封闭完成,从输入信息录入,到模型内部运算,再到输出结果生成,全程无数据外传风险,严守商业机密、个人隐私底线,因而能放心应用于金融数据解析、医疗病历处理等对隐私要求严苛领域。

- 参数调控精准定制:深知不同业务场景对模型输出有差异化诉求,LM Studio赋予用户灵活的参数调控权。“温度”参数可调整输出文本的灵活度,取值趋近于0时,结果严谨规范、遵循既有逻辑;适当调高则激发更多创意表达。“重复惩罚”参数把控文本多样性,规避单调重复表述,以此助力写作、翻译、创意构思等工作产出更契合需求、风格各异的优质文本。

- 文本嵌入强化检索:自0.2.19版本引入的文本嵌入功能意义重大,借助POST /v1/embeddings端点生成文本嵌入向量,融入检索增强生成(RAG)架构体系,在海量文档、知识库搜索场景表现卓越。科研人员检索文献、企业梳理内部资料时,能凭借此先精准锁定关联信息,再结合语言模型智能整合润色,大幅提升知识利用效率。

四、快速上手指引

1. 环境搭建与安装准备

- 核验硬件适配性:使用前需确认设备硬件配置。Windows系统下,要求设备为支持AVX2处理器的x86或x64架构PC,显存建议达6GB及以上保障流畅度;Mac端需搭载macOS 13.6及后续更新版本的Apple Silicon(M1/M2/M3/M4等);Linux系统需支持AVX2处理器的PC(当前Linux版尚处测试完善阶段),且各系统均推荐准备至少16GB系统内存,为模型加载预留充足空间。

- 获取安装程序:访问LM Studio官方网站,依自身操作系统类别下载对应安装包,按常规软件安装步骤完成安装,过程中按需设置安装路径等基础参数。

2. 模型选取及下载步骤

- 启动应用:安装完毕,开启LM Studio,映入眼帘的主界面布局简洁、功能板块清晰。

- 探索模型资源库:在主界面定位“模型库”板块进入,这里汇聚LM Studio整合自外部资源的海量模型,既有通用性模型,也有面向特定领域(如编程、写作专属类)模型。用户可借助搜索框输入关键词(如“Llama 2”)快速定位,或依分类标签(“写作类”“代码类”等)筛选心仪模型。

- 执行下载操作:选定目标模型后,点击旁侧“下载”按钮,程序自动从云端拉取模型文件存至本地指定目录,下载进度实时显示,依模型大小,耗时数分钟到半小时不等,下载全程需确保网络稳定。

3. 本地运行与交互实操

- 启用本地服务器(按需操作):若计划与外部基于OpenAI API开发应用集成,切换至“本地服务器”标签,于下拉菜单选定已下载好的模型,点击“启动服务器”按钮(默认端口1234,可按需自定义),成功启动后界面会反馈状态信息,示意可开展外部连接操作。

- 开启交互对话:回到主界面“聊天”或“交互”板块,在输入框录入指令或询问内容(如“请撰写一篇人工智能技术应用的文章开头”),点击“发送”或按回车键,LM Studio驱动本地模型运算,片刻后输出结果展示于下方框内,交互中还可利用侧边栏参数滑块实时微调“温度”“重复惩罚”等参数,优化输出文本质量。

五、多元应用场景

- 助力个人创作工作:对于作家、博主等创作者群体,LM Studio是得力创作助手。构思故事时,助其突破情节阻碍、拓展新奇设定;撰写文案时,精雕语句、渲染氛围轻松达成,还能按需模拟多种文风,产出兼具质量与特色的作品。

- 赋能企业智能客服:企业引入LM Studio搭建本地智能客服“大脑”,经针对性训练适配业务逻辑后,能对常见咨询秒级回应,依客户过往记录、提问情境给予贴心解答,相较传统人工检索话术式客服,效率大幅跃升,同步降低人力成本,优化运营效益。

- 辅助学术科研进程:在学术科研战线,LM Studio辅助师生梳理文献、凝练观点、生成综述材料。面对实验设计难题,提供思路参考、评估方案可行性;撰写论文阶段,助力规范格式、润色语句,为科研成果清晰表达“添砖加瓦”。

六、结语

在未来的智能科技蓝图中,LM Studio将继续以其卓越的技术实力和创新能力,引领本地大型语言模型的发展潮流。它不仅极大地丰富了人工智能的应用场景,还为用户提供了一种全新的、个性化的智能交互体验。随着技术的持续进步和功能的不断完善,LM Studio有望在保障用户隐私安全的同时,实现更快速的响应和更精准的服务,从而满足各行各业对智能技术的多元化需求。我们有理由相信,LM Studio将在智能科技的道路上越走越远,为人类社会带来更多的便利和惊喜。

GitHub地址:https://github.com/lmstudio-ai

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:我是寻道AI小兵,资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索。

📖 技术交流:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,加入技术交流群,开启编程探索之旅。

💘精心准备📚500本编程经典书籍、💎AI专业教程,以及高效AI工具。等你加入,与我们一同成长,共铸辉煌未来。

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我,让我们携手同行AI的探索之旅,一起开启智能时代的大门!

免责声明:本内容来源于网络,如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |