🌟 各位看官号,我是egoist2023! 🌍 种一棵树最好是十年前,其次是现在! 🚀 今天来学习如何通过蓝耘智算使用DeepSeek R1模型 👍 如果觉得这篇文章有帮助,欢迎您一键三连,分享给更多人哦 目录 一、前言 DeepSeek平台的当前弊端 二、DeepSeek-R1 的核心特点 三、蓝耘智算是什么? 四、蓝耘智算搭建DeepSeek-R1模型 一、前言DeepSeek因其优秀的推演能力、强大的模型训练以及更少的资金培养,是近期爆火的开源大模型。然而,随着用户需求的增长,DeepSeek在大数据和高频访问的场景下经常面临服务器不稳定的问题。 DeepSeek平台的当前弊端

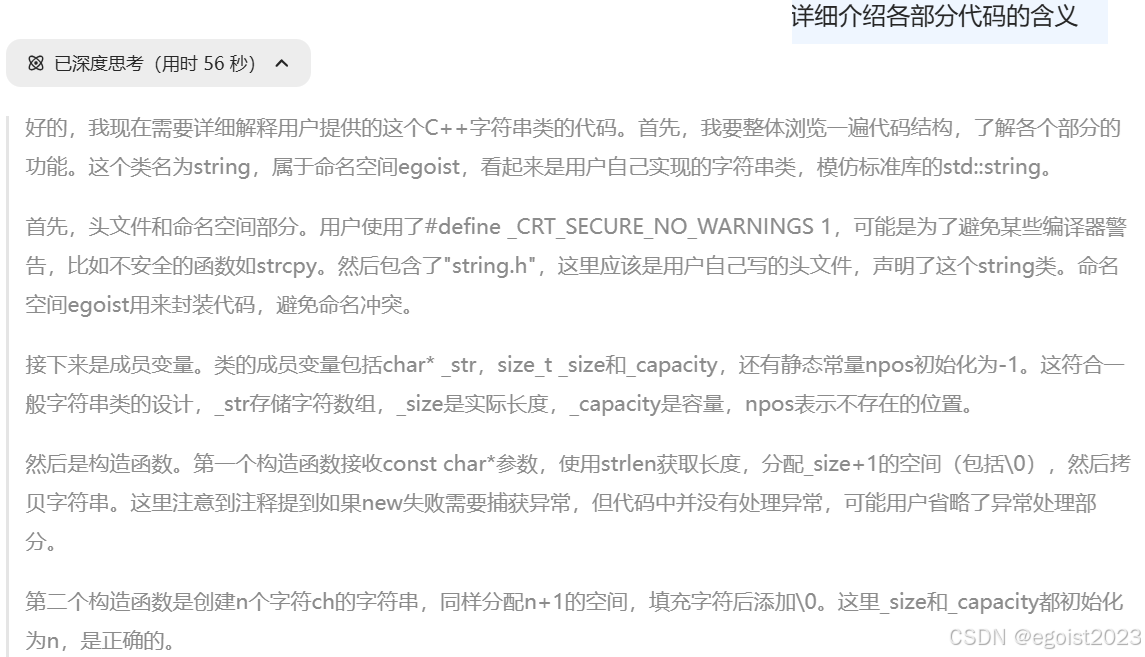

在使用DeepSeek平台的时候,经常会面临如下问题: 在deepseek官网上使用deepseek R1的深度思考功能,在处理较长文本的时候思考的时间过长,不能给用户提供更高效、智能的服务体验。  甚至在面临多用户的高频访问时,会出现“服务器繁忙,请稍后再试”的字样,对用户造成了不佳体验。  因此,本文通过使用蓝耘智算搭建DeepSeek R1模型 以充分发挥DeepSeek的性能和稳定性。 二、DeepSeek-R1 的核心特点

三、蓝耘智算是什么?蓝耘智算是一家专注于高性能计算(HPC)、云计算或人工智能算力服务的科技公司。蓝耘智算平台搭载了智能调度系统,能够根据任务需求动态分配算力资源,确保高效利用计算资源,并大幅缩短任务执行时间。 通过蓝耘智算平台搭建DeepSeek-R1模型的优势:

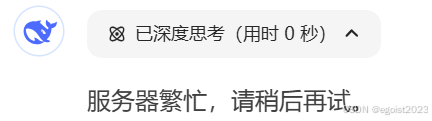

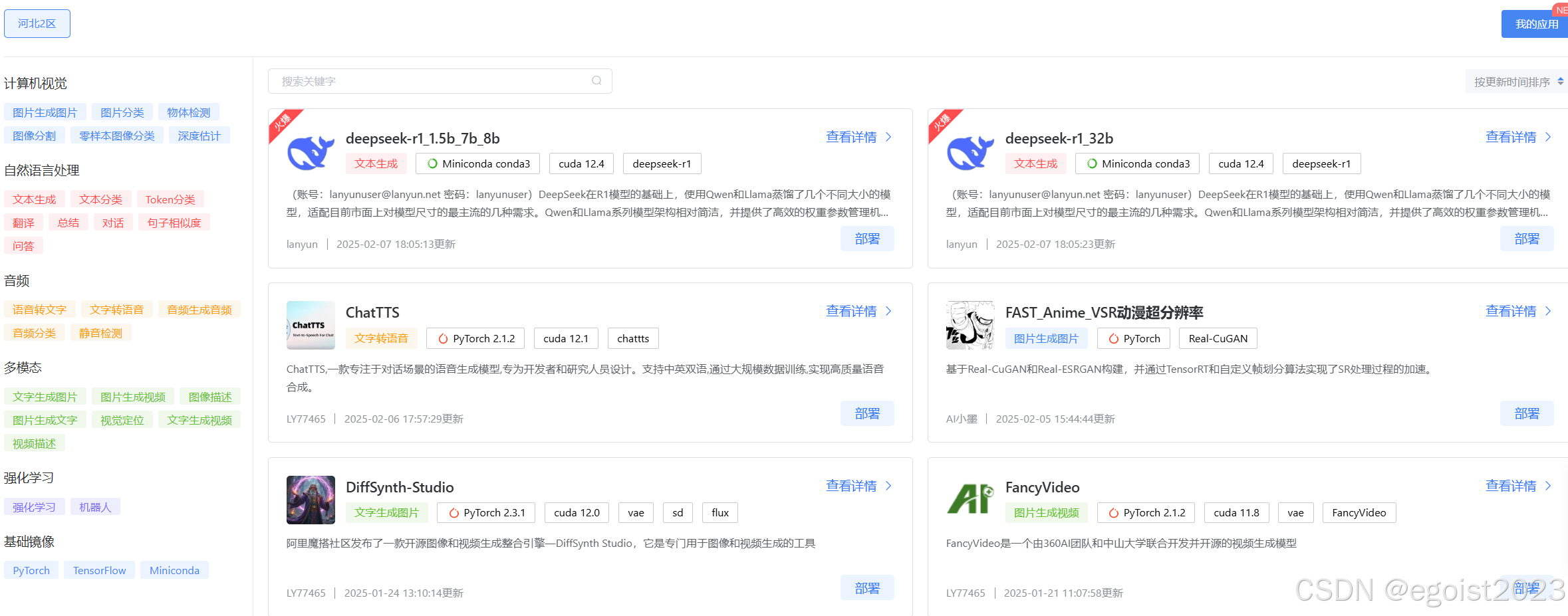

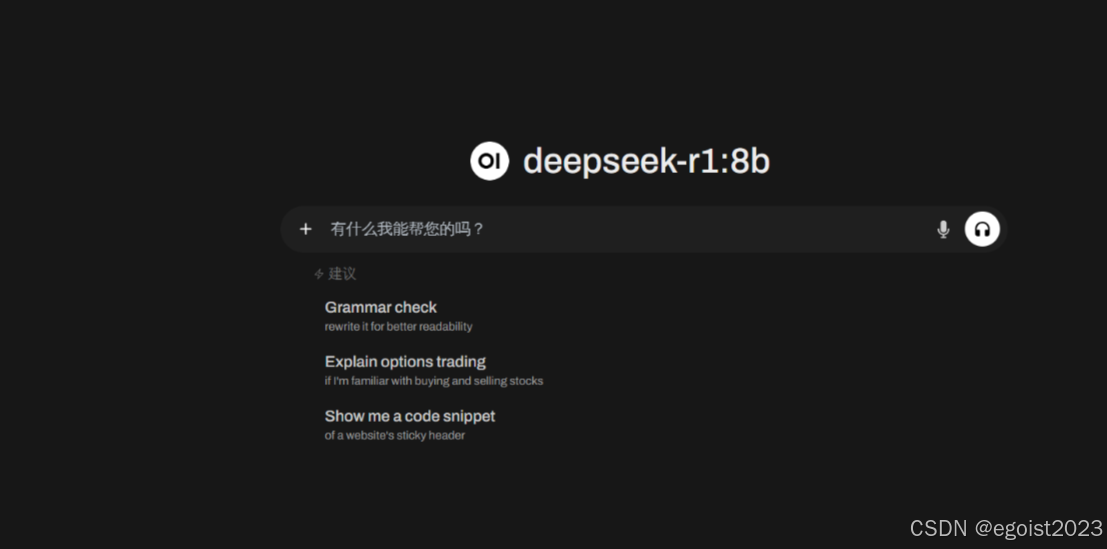

四、蓝耘智算搭建DeepSeek-R1模型通过此链接 https://cloud.lanyun.net//#/registerPage?promoterCode=0131 进行注册。 注册成功后,可以在此平台看到应用市场,进行点击  进入应用市场后,就能看到DeepSeek-R1模型的部署,且蓝耘平台提供了多种深度学习模型,涉及计算机视觉、音频、自然语言处理等多种领域。  这里以deepseek-r1_1.5b_7b_8b模型为例,点击部署。 【应用介绍】DeepSeek在R1模型的基础上,使用Qwen和Llama蒸馏了几个不同大小的模型,适配目前市面上对模型尺寸的最主流的几种需求。Qwen和Llama系列模型架构相对简洁,并提供了高效的权重参数管理机制,适合在大模型上执行高效的推理能力蒸馏。蒸馏的过程中不需要对模型架构进行复杂修改 ,减少了开发成本。【默认账号:lanyunuser@lanyun.net 密码:lanyunuser】  这里直接选择4090进行安装(不是4090的电脑也无碍)。因为主要依赖于平台的算力资源池、虚拟化技术和远程计算服务。用户无需本地拥有4090 GPU,即可通过平台高效利用高性能硬件资源。这种模式降低了用户硬件成本,同时提升了计算效率。  创建好后点击右上角的快速启动应用就能运行我们DeepSeek-R1模型  接下来进行登录【默认账号:lanyunuser@lanyun.net 密码:lanyunuser】  登录后就会出现这个页面,即DeepSeek-R1模型的可视化界面。  附上平台注册链接:   免责声明:本内容来源于网络,如果侵犯了您的权益,请联系站长,我们会及时删除侵权内容,谢谢合作! |